SeaArt AI 创造无限可能

以AI为笔,绘你所想,创作令人惊叹的艺术作品。

立即开始

全新UniAnimate开源项目,轻松实现AI图片跳舞

2 分钟阅读

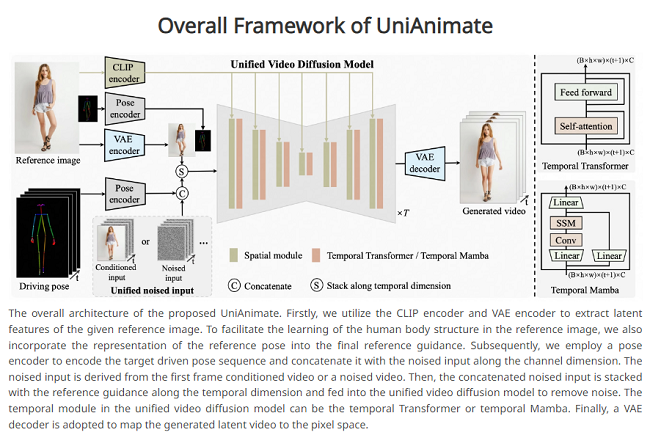

最近阿里巴巴联合华中科技大学,开源了一个令人瞩目的新项目——UniAnimate。这个项目能让静态图片中的人物“活”起来,AI图片跳舞,轻松生成高保真、时间平滑的动画视频。

UniAnimate项目的核心是通过一个统一的视频扩散模型和噪声输入,优化人体结构学习,生成流畅且自然的动画效果。项目的设计目标是将图片与动作指令转化为流畅的视频,特别适用于人类跳舞视频和高效的人像动画生成。

主要特点:

1. 统一视频扩散模型:引入先进的统一视频扩散模型,保证生成效果的连贯性和自然性。

2. 编码器提取潜在特征:采用先进的编码器,确保人体动画生成时的高保真效果。

3. 个性化动画生成:支持根据特定创意或需求生成个性化的动画内容。

怎么免费快速的生成AI图片跳舞——实操步骤

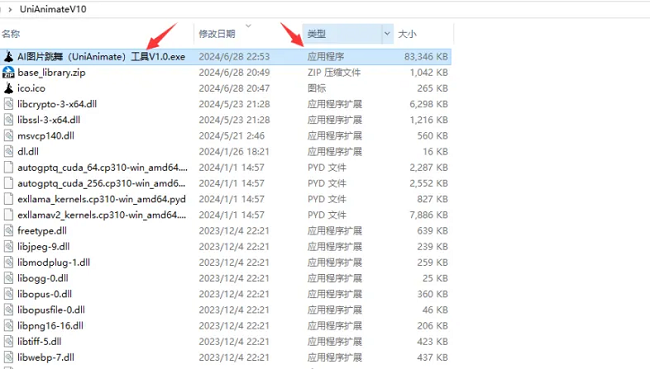

第一步:下载并运行程序

下载安装AI图片跳舞应用程序,双击启动。

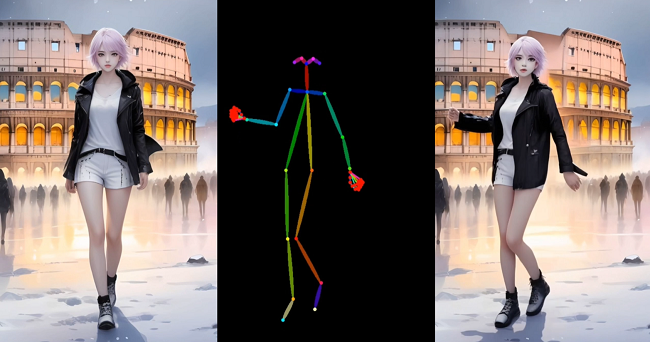

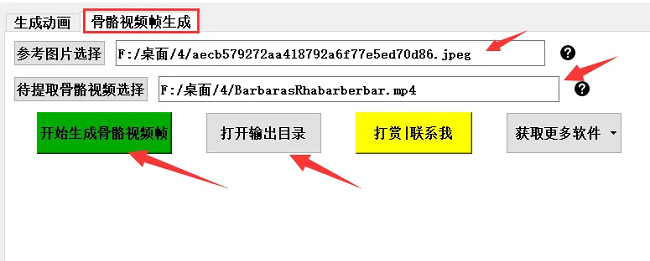

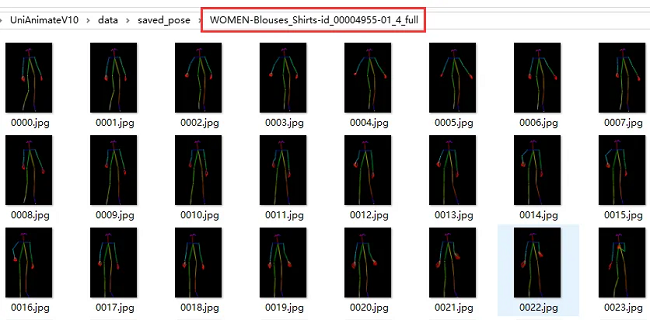

第二步:生成骨骼视频

上传参考图片和想要的舞姿视频,点击开始生成骨骼视频帧。骨骼视频帧将作为后续视频生成的基础。

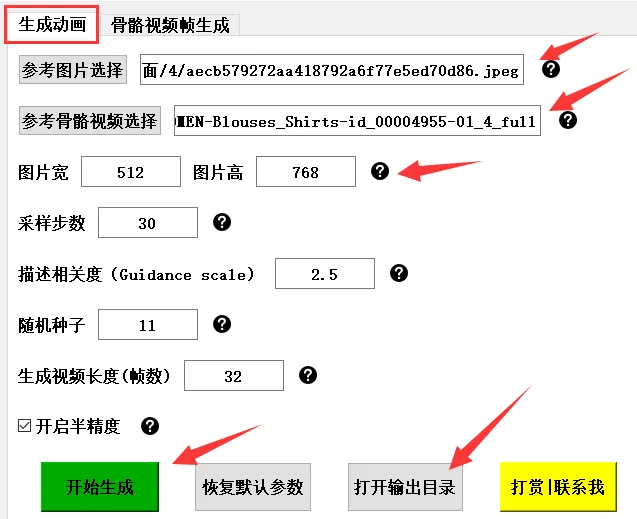

第三步:生成动画视频

在视频生成界面,选择人物照片和生成的视频路径,点击生成并耐心等待,生成的视频将自动保存在输出目录中。

总结

在使用UniAnimate这一AI图片跳舞工具时,尽可能使用正面全身照的人物图片,图片背景尽可能干净。这一技术可应用于短视频动漫内容制作,教学视频的生动化、个性化广告制作等。